[Alerte] Le nouveau modèle "o3" d'OpenAI EXPLOSE tous les scores

Après même si on avait l'IA parfaite qui pourrait remplacer à bas cout tout les métiers du monde là maintenant, le temps que tout les structures humaine décident de les adoptés un à un, sera biiiiiiiiennnn plus long

Il y a qu'a voir tout le système de la bourse qui fonctionne toujours à coup de fichier excel alors qu'on a maintenant plein d'outils bien plus pratique, sur et efficient qui existent

Le 21 décembre 2024 à 13:51:02 :

Pour les boites côtés en bourse ou ayant besoin d’investissement on est d’accordPar contre on a aucune idée de ce qui se trame au niveau de La Défense de pays comme les us

oui

la defense US et chinoise notamment doivent avoir des IA de tarax

on doit meme pas imaginer

Le 21 décembre 2024 à 13:46:51 Trump2027 a écrit :

Le 21 décembre 2024 à 13:44:37 :

Le 21 décembre 2024 à 13:37:36 Coa170 a écrit :

Le problème c'est le coût de calculexact ca me soule un peu d'entendre des gens qui y connaisse rien à l'ia chier dessus avec des arguments pétés, et oui l'ia est bien capable de te remplacer jean-code seulement en l'etat ca couterai plus cher à ton employeur que ton salaire car le processus d'auto verification est tres couteux en token

par contre vos argument "agneu gneu ca replacera l'ame et la chaleur humaine" ou "oui mais il connait pas le framework de merde qu'un plouk à codé dans son coin et que personne utilise" -> de la merde

oui mais le cout c'est juste une question de temps....

oui mais t'en sais rien l'evolution de nos gpu à pas fait du x1000.000 entre aujourd'hui et il y a 10ans il y a que sur le software ou on a possiblement de la marge mais ca risque pas d'etre exponentiel comme on pourrait le penser.

c'est comme le jeux video, le gap entre la nes et la ps1 etais geant pour le grand public (on peut comparer cela au passage entre le correcteur automatique / diction vocale et version 3 de chat gpt) la on est à la ps2-ps3, on à des modèles bien plus avancés des multi-modèles capable de comprendre les images et la voix mais et on arrive à crééer des images quasi indiferentiables avec les modèles de diffusion ... (comme certains preview de jeu ps3 à l'epoque) mais dans le gameplay on vois bien qu'on y est pas encore , l'evolution qui viens ensuite (ps4, ps5 est bien moins visible aux yeux du grand public car elle demande bien plus de puissance pour des resultats de moins en moins visible et on est au stade ou les evolutions hardware sont déja au max de leur miniaturisation)

le plus probable c'est d'avoir des artefact d'ingenieurie logicielle mais le modèlle en sois je pensse pas qu'il evolue beaucoup ca reste un llm

Le 21 décembre 2024 à 12:19:52 KheyDaltoOUI a écrit :

Le 21 décembre 2024 à 12:17:45 :

Le problème c’est aussi le détail derrière les pourcentages

Le problème de l’IA c’est que même si ça te répond 97% du temps bon, dans les 3% du temps qui reste ça peut faire de la grosse grosse grosse merdeCe qu’un humain qualifié ne fera pas même si admettons il réussit 90% du temps

Les extrêmes sont très importants. Imagine tu as un client, tu le gères bien et d’un coup tu petes un câble tu te mets à jouer du piano avec ta bite. C’est over.

"Les machines dans les usines c'est bien 99 % du temps mais si dans 1 % des cas ça déconne l'usine prend feu, les machines remplaceront jamais les humains"

Il y a une différence entre mettre feu à usine et une IA qui pourrait bouleversé tout le court économique de la planète

Le 21 décembre 2024 à 13:53:34 yumekua3 a écrit :

Après même si on avait l'IA parfaite qui pourrait remplacer à bas cout tout les métiers du monde là maintenant, le temps que tout les structures humaine décident de les adoptés un à un, sera biiiiiiiiennnn plus long

Il y a qu'a voir tout le système de la bourse qui fonctionne toujours à coup de fichier excel alors qu'on a maintenant plein d'outils bien plus pratique, sur et efficient qui existent

Mouais, je pense qu'une IA ultra compétitive qui te permet de cut tes charges salariales par 4 ou plus ça prendra pas beaucoup de temps avant de se mettre en place

Les entreprises peuvent changer drastiquement assez rapidement si elles le "veulent" vraiment

Le 21 décembre 2024 à 13:57:58 Campbellrefor11 a écrit :

Le 21 décembre 2024 à 13:53:34 yumekua3 a écrit :

Après même si on avait l'IA parfaite qui pourrait remplacer à bas cout tout les métiers du monde là maintenant, le temps que tout les structures humaine décident de les adoptés un à un, sera biiiiiiiiennnn plus long

Il y a qu'a voir tout le système de la bourse qui fonctionne toujours à coup de fichier excel alors qu'on a maintenant plein d'outils bien plus pratique, sur et efficient qui existent

Mouais, je pense qu'une IA ultra compétitive qui te permet de cut tes charges salariales par 4 ou plus ça prendra pas beaucoup de temps avant de se mettre en place

Les entreprises peuvent changer drastiquement assez rapidement si elles le "veulent" vraiment

Si il le veulent, c'est bien ça le problème

Il y a mille et une façon de moderniser l'infrastructure de la bourse, mais c'est tellement un domaine tricky, à fort enjeu planétaire et avec beaucoup trop d'acteurs qui y interagie qu'on préfère encore bosser sur des outils de mathusalem

Le 21 décembre 2024 à 13:57:58 :

Le 21 décembre 2024 à 13:53:34 yumekua3 a écrit :

Après même si on avait l'IA parfaite qui pourrait remplacer à bas cout tout les métiers du monde là maintenant, le temps que tout les structures humaine décident de les adoptés un à un, sera biiiiiiiiennnn plus long

Il y a qu'a voir tout le système de la bourse qui fonctionne toujours à coup de fichier excel alors qu'on a maintenant plein d'outils bien plus pratique, sur et efficient qui existent

Mouais, je pense qu'une IA ultra compétitive qui te permet de cut tes charges salariales par 4 ou plus ça prendra pas beaucoup de temps avant de se mettre en place

Les entreprises peuvent changer drastiquement assez rapidement si elles le "veulent" vraiment

exact

d'ailleurs au moment du covid on a vu qu'elles ont été rapide a passer en télétravail

on a oublié qu'avant 2020 le TT était quasi inexistant

Le 21 décembre 2024 à 13:59:56 yumekua3 a écrit :

Le 21 décembre 2024 à 13:57:58 Campbellrefor11 a écrit :

Le 21 décembre 2024 à 13:53:34 yumekua3 a écrit :

Après même si on avait l'IA parfaite qui pourrait remplacer à bas cout tout les métiers du monde là maintenant, le temps que tout les structures humaine décident de les adoptés un à un, sera biiiiiiiiennnn plus long

Il y a qu'a voir tout le système de la bourse qui fonctionne toujours à coup de fichier excel alors qu'on a maintenant plein d'outils bien plus pratique, sur et efficient qui existent

Mouais, je pense qu'une IA ultra compétitive qui te permet de cut tes charges salariales par 4 ou plus ça prendra pas beaucoup de temps avant de se mettre en place

Les entreprises peuvent changer drastiquement assez rapidement si elles le "veulent" vraiment

Si il le veulent, c'est bien ça le problème

Il y a mille et une façon de moderniser l'infrastructure de la bourse, mais c'est tellement un domaine tricky, à fort enjeu planétaire et avec beaucoup trop d'acteurs qui y interagie qu'on préfère encore bosser sur des outils de mathusalem

J'ai mis "veulent" en parenthèses pour une bonne raison, je suis pas un grand partisan des lois du marché, mais si il y a bien un truc de sûr, c'est qu'un tel potentiel d'économies ne pourra pas être ignoré

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.

Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

Le 21 décembre 2024 à 14:06:16 dabhu00 a écrit :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

j'ai cru entendre qu'il n'y avais plus tellement de volonté que d'ajouter des données d'entraînement justement pour le pas pourrir le modèle

Le 21 décembre 2024 à 11:12:46 :

Cette compet fait tellement pitié bordelLa course a quel modèle va nous anéantir en premier

La même pensée

Le 21 décembre 2024 à 14:06:16 dabhu00 a écrit :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

Y'a rien qui empêche de continuer à entrainer les IA sur des données d'avant 2022 pour ne pas s'autodétruire. On a un dataset qui est largement suffisant jusqu'à atteindre un stade ou l'IA pourra s'améliorer avec ses propres données et la tout s'accélèrera.

La dégénérescence peut largement être éviter;

Le 21 décembre 2024 à 14:06:16 :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

This

L’IA va s’auto abrutir avec des articles vers l’IA

Pour ceux qui stress quant au boulot, il ne faut pas avoir peur, tous les jobs avec main d’œuvre ne bougeront pas, ce qui risque de changer c’est surtout les taffs du tertiaire en premier lieux

Le 21 décembre 2024 à 14:08:01 :

Le 21 décembre 2024 à 14:06:16 dabhu00 a écrit :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

j'ai cru entendre qu'il n'y avais plus tellement de volonté que d'ajouter des données d'entraînement justement pour le pas pourrir le modèle

Oui mais le gros facteur limitant des modèles c'est justement la quantité de data (les tres gros modèles sont "underfit"). Si on a pas accès à plus de data, le seul moyen d'améliorer les performances actuels c'est soit en changeant complètement la logique d'entrainement, soit via du prompt engineering très ciblé.

Dans le cas de o3 on a aucune idée de ce qu'ils ont fait pour péter les benchmarks. Attention ça reste impressionnant, mais rien ne dit que justement tout a été bricolé pour optimiser ces benchmarks.

Le 21 décembre 2024 à 14:10:32 dabhu00 a écrit :

Le 21 décembre 2024 à 14:08:01 :

Le 21 décembre 2024 à 14:06:16 dabhu00 a écrit :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

j'ai cru entendre qu'il n'y avais plus tellement de volonté que d'ajouter des données d'entraînement justement pour le pas pourrir le modèle

Oui mais le gros facteur limitant des modèles c'est justement la quantité de data (les tres gros modèles sont "underfit"). Si on a pas accès à plus de data, le seul moyen d'améliorer les performances actuels c'est soit en changeant complètement la logique d'entrainement, soit via du prompt engineering très ciblé.

Dans le cas de o3 on a aucune idée de ce qu'ils ont fait pour péter les benchmarks. Attention ça reste impressionnant, mais rien ne dit que justement tout a été bricolé pour optimiser ces benchmarks.

à voir effectivement, il y a un classement sur Hugging Face qui recense le ressenti des utilisateur sur les modèles privés

Le 21 décembre 2024 à 14:10:01 CrocsPorsche a écrit :

Le 21 décembre 2024 à 14:06:16 :

Je reste sceptique perso alors que je suis un grand fan de GPT de la première heure.Leur modèle o1 était soit disant fantastique, mais, l'ayant testé de long en large, j'ai pas trouvé qu'il était si exceptionnel que ça alors que tout le monde criait à la révolution (GPT 4o1 restait au dessus selon moi sur plein de taches, et Claude 3.5 pulverisais o1)

On connait rien de ce modèle o3. Mais il y a une chose dont je suis sure, c'est que c'est très facile d'orienter un modèle pour péter un benchmark en particulier. Ca s'appelle de l'overfitting. Bref, j'attends de voir ce que ça donne concrètement perso.

A noter aussi que les nouvelles IA vont être confronté de plus en plus à un autre problème: là où ils pouvaient s'entrainer sur un net "propre" (= généré par des humains) jusqu'à maintenant, c'est malheureusement plus le cas aujourd'hui et ça va entrainer une dégénerescence des prochains modèles.

This

L’IA va s’auto abrutir avec des articles vers l’IA

Pour ceux qui stress quant au boulot, il ne faut pas avoir peur, tous les jobs avec main d’œuvre ne bougeront pas, ce qui risque de changer c’est surtout les taffs du tertiaire en premier lieux

et donc la majorité des emplois dans les économies occidentales

+ les métiers manuels disparaissent déjà et de plus en plus grâce à l'automatisation

Le 21 décembre 2024 à 13:40:56 :

Le 21 décembre 2024 à 13:32:58 Afueraaaaa a écrit :

Le 21 décembre 2024 à 11:09:08 :

Aya c'est la fin mes kheys. Pour de vrai cette fois.OpenAI ont annoncé leur nouveau modèle de "chaîne de pensées" et c'est un nouveau bond technologique. On est encore loin du plateau des IA.

En gros il y a un test nommé ARC-AGI qui sert de référence pour tester le raisonnement des modèles sur des tâches faciles pour les humains

.gif)

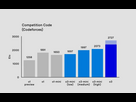

Le modèle d'OpenAI a atteint 88% de réussite ce qui est du jamais vu.Ils ont aussi testé "o3" sur Codeforces qui est le site le plus populaire de programmation compétitive. Faut être une brute intellectuelle pour bien se classer sur ce site.

Ça demande des connaissances algorithmiques poussées, mais surtout, ça demande de la créativité pour trouver la bonne solution aux problèmes les plus difficiles.

Je vous le donne dans le mille : "o3" surclasse 99,8% des concurrents, l'équivalent d'un classement #175 sur le site :

Et après vous allez dire "gneu gneu c'est pas représentatif du travail d'ingénieur informatique".

Vous avez raison. Sauf qu'il y a aussi un autre test (SWE-bench) qui consiste à lui faire résoudre des bugs sur Github.

Le modèle réussit à 77% :

Autant dire que ça peut remplacer une énorme partie des devs.Les autres disciplines sont pas sans reste.

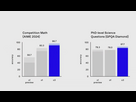

En mathématiques, examen prestigieux réservé aux 5% des meilleurs élèves US97% de réussite

Sur les questions générales en Science de niveau PHD / expert88% de réussite

Un test en maths ultra poussé, spécifiquement créé pour être ultra dur au IA. Même Terence Tao n'envisageait pas qu'il puisse être résolu avec succès avant un bon paquet d'années...

Le nouveau modèle est passé de 2% à 25% de réussite :

TOUS les spécialistes, même les plus sceptiques jusque là, sont d'accord pour dire que c'est une avancée notoire et absolument choquante.

Bientôt plus d'artistes, plus de journalistes, plus de devs, plus de médecins, plus d'avocats... On est FINITO.

Dis-moi que tu ne sais pas en quoi consiste le travail d'un développeur sans dire que tu ne le sais pas

T'es juste dans le déni.

T'es pisseur de code et je dis pas ça pour troller. Je peux te dire quand dans ma boîte où certains bugs peut se traduire par une convocation du PDG au ministère de l'intérieur (c'est arrivé pour Orange quand ils avaient mis un bug dans le code qui gère la plateforme d'appels d'urgence), on ne va pas s'amuser à pousser en prod du code généré par IA sans aucun contrôle humain derrière.

On rappel que OpenAI annonçait déjà l'AGI avec o1. Ensuite ils ont dit "oui alors en fait on a revu notre définition d'AGI".

La vérité c'est qu'OpenAI est en perdition et ils essayent de faire le buzz pour rameuter plus de financement (on rappel que ces modèles sont des gouffres financiers).

C'est pas pour rien non plus qu'ils ont mis à disposition SORA leur modèle de génération d'image récemment. Ils perdent des parts de marché vis à vis de la concurrence (Claude 3.5 d'Anthropic notamment), donc ils paniquent et tous leurs gros cadres techniques se sont barrés.

Je vois pas le rapport avec "remplacer" les médecins l OP

Perso je me sers de GPT dans mon boulot, il m'aide pour des prises en charges si j'ai un doute, mais ce n'est pas lui qui va faire l ECG ni l écho ni lire ou poser des pacemakers ni faire la coro ni le scanner ou la scinti. Il ne va pas parler aux patients a ma place ni leurs donner mon avis sur la politique française comme je le fais souvent.

Bref l IA ne doit pas être repoussée bien au contraire il faut savoir sen servir comme d'un outil

Données du topic

- Auteur

- DemainJeNique

- Date de création

- 21 décembre 2024 à 11:09:08

- Nb. messages archivés

- 239

- Nb. messages JVC

- 235